- Avtor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:53.

- Nazadnje spremenjeno 2025-01-22 17:40.

Laično povedano, sebe - pozornost mehanizem omogoča medsebojno interakcijo vhodov (“ sebe ”) in ugotovite, komu bi morali plačati več pozornost do ( pozornost ”). Izhodi so agregati teh interakcij in pozornost rezultatov.

In kaj je pozornost nase?

sebe - pozornost , včasih imenovan intra- pozornost je pozornost mehanizem, ki povezuje različne položaje posameznega zaporedja, da se izračuna predstavitev zaporedja.

Prav tako, kaj je pozornost pri globokem učenju? Najprej opredelimo, kaj » sebe - Pozor ” je. Cheng et al, v svojem prispevku z naslovom »Mreža dolgotrajnega pomnilnika za Stroj Branje«, opredeljeno sebe - Pozor kot mehanizem povezovanja različnih položajev posameznega zaporedja ali stavka, da bi dobili bolj živo predstavo.

Kaj je v zvezi s tem mehanizem pozornosti?

Mehanizem za pozornost omogoča dekoderju, da upošteva različne dele izvornega stavka na vsakem koraku generiranja izhoda. Namesto da bi kodirali vhodno zaporedje v en sam fiksiran kontekstni vektor, smo modelu pustili, da se nauči generirati kontekstni vektor za vsak izhodni časovni korak.

Kaj je model, ki temelji na pozornosti?

Pozor - zasnovani modeli spadajo v razred modeli običajno imenujemo zaporedje v zaporedje modeli . Cilj teh modeli , kot že ime pove, za izdelavo izhodnega zaporedja glede na vhodno zaporedje, ki je na splošno različnih dolžin.

Priporočena:

Kako deluje proxy Spring AOP?

AOP proxy: objekt, ki ga je ustvaril okvir AOP za izvajanje pogodb vidika (svetovanje o izvedbi metod in tako naprej). V Spring Framework bo proxy AOP dinamični proxy JDK ali proxy CGLIB. Tkanje: povezovanje vidikov z drugimi vrstami aplikacij ali predmeti za ustvarjanje priporočenega predmeta

Kako deluje ogledalo TV?

Ogledalo TV je sestavljeno iz posebnega polprozornega ogledalnega stekla z LCD TV za zrcalno površino. Ogledalo je skrbno polarizirano, da omogoča prenos slike skozi ogledalo, tako da je naprava, ko je televizor izklopljen, videti kot ogledalo

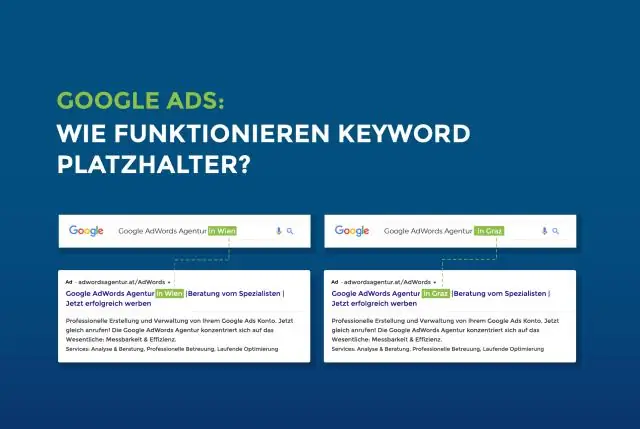

Kako deluje nadomestno mesto?

Atribut placeholder določa kratek namig, ki opisuje pričakovano vrednost vnosnega polja (npr. vzorčna vrednost ali kratek opis pričakovane oblike). Opomba: atribut nadomestnega mesta deluje z naslednjimi vrstami vnosa: besedilo, iskanje, url, tel, e-pošta in geslo

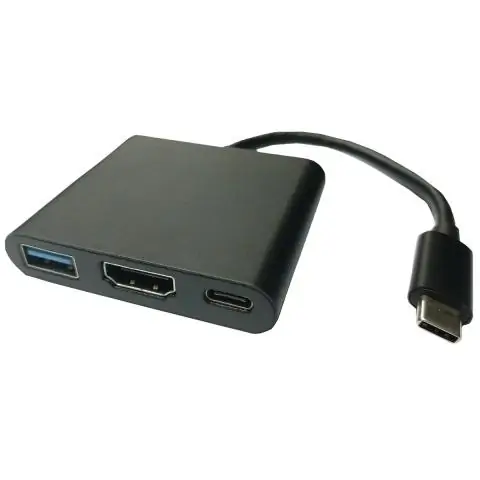

Kako deluje zaslonski adapter USB?

Video adapterji USB so naprave, ki sprejmejo ena vrata USB in se povežejo z eno ali več video povezavami, kot so VGA, DVI, HDMI ali DisplayPort. To je uporabno, če želite v nastavitve računalnika dodati dodaten zaslon, vendar nimate video povezav na vašem računalniku

Kako deluje koda za odpravljanje napak?

Koda za odpravljanje napak je algoritem za izražanje zaporedja številk, tako da je mogoče vse uvedene napake odkriti in popraviti (znotraj določenih omejitev) na podlagi preostalih številk. Študija kod za popravljanje napak in s tem povezane matematike je znana kot teorija kodiranja